🎄 연말 분위기가 사라진 거리의 이유

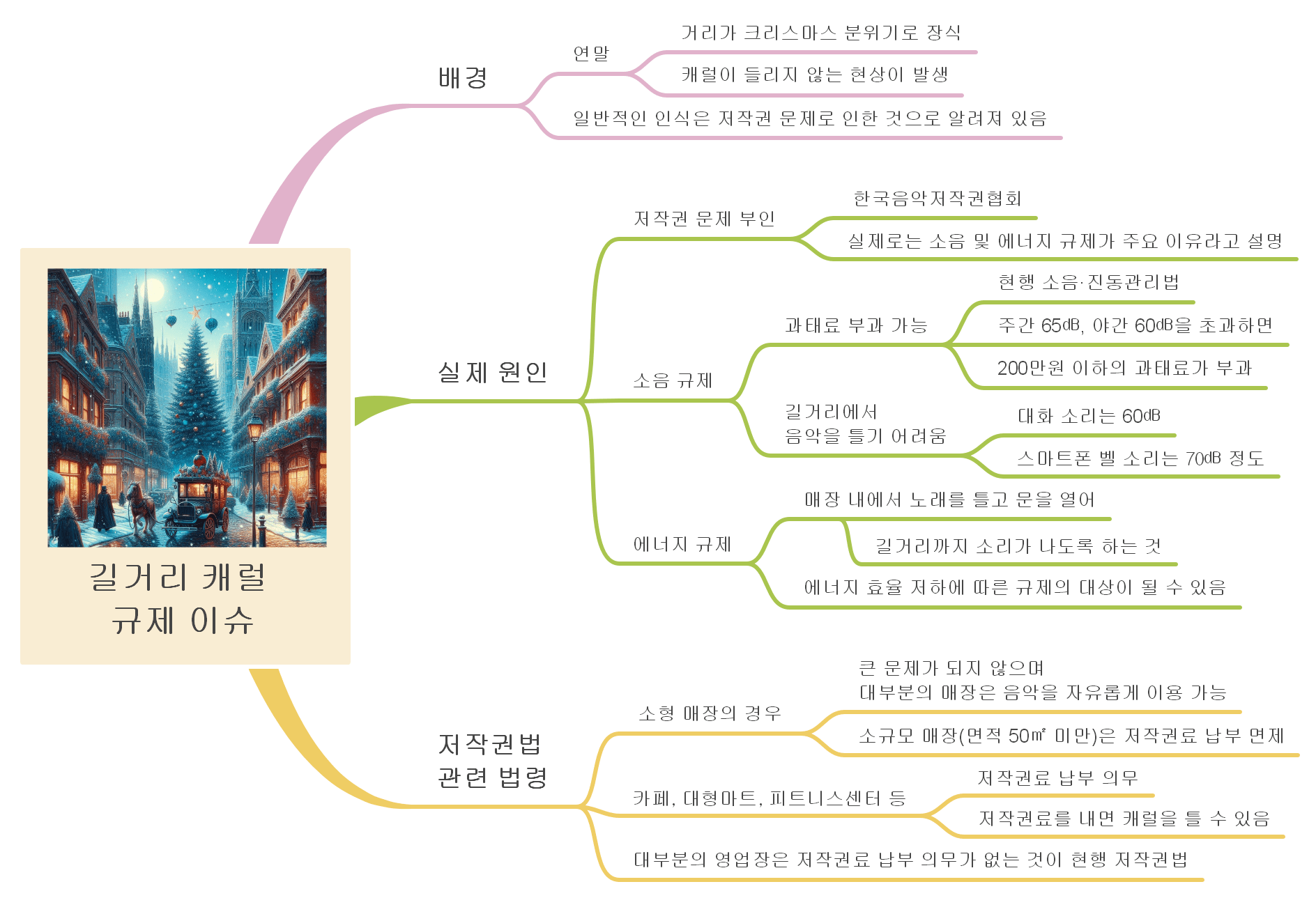

연말이 되면 거리 곳곳이 화려한 크리스마스 장식으로 꾸며지고 캐럴이 울려 퍼지는 풍경이 익숙하다. 그러나 최근 몇 년간 거리에서 캐럴 소리가 점점 사라지고 있다. 많은 사람들은 이를 저작권 문제 때문이라고 생각하지만, 실제로는 다른 이유가 숨어 있다.

📢 소음 규제, 캐럴을 멈추게 하다

🔇 소음 규제의 강력한 영향

한국음악저작권협회는 저작권 문제가 아니라 소음 규제와 에너지 효율 관련 규제가 주요 원인이라고 설명한다.

현재 소음·진동관리법에 따르면 주간 65㏈, 야간 60㏈을 초과하면 최대 200만 원 이하의 과태료가 부과될 수 있다.

길거리 음악의 소리는 대화 소리(60㏈)나 스마트폰 벨소리(70㏈) 정도와 유사한 수준으로, 규제를 피하기 어렵다.

🔊 길거리에서 음악이 멈춘 이유

거리에서 음악을 틀 경우 소음으로 민원이 발생할 수 있고, 과태료 부과 대상이 될 수 있어 많은 매장이 캐럴을 틀지 않는다.

💡 에너지 규제와 캐럴의 관계

🚪 문을 열고 음악을 틀면?

매장 안에서 캐럴을 틀며 문을 열어 두는 경우, 소리가 길거리로 퍼지게 된다. 이는 에너지 효율 저하 문제로 이어져 규제 대상이 될 수 있다.

에너지 절약이 강조되는 시대에 이런 방식의 음악 재생은 매장 운영에도 부담을 줄 수 있다.

📜 저작권 문제는 실제로 얼마나 영향을 줄까?

🏪 소형 매장과 저작권법

많은 소형 매장(면적 50㎡ 미만)은 현행 저작권법에 따라 저작권료 납부 의무에서 면제된다. 따라서 이들 매장은 캐럴을 자유롭게 틀 수 있다.

🏬 대형 매장의 저작권료 납부 의무

카페, 대형마트, 피트니스센터 등은 저작권료를 납부해야 한다. 그러나 저작권료를 내면 캐럴을 틀 수 있어, 저작권 자체가 큰 걸림돌이 되지는 않는다.

🎶 규제와 저작권의 상관관계

대부분의 매장은 저작권료를 납부하지 않아도 음악을 틀 수 있다. 따라서 캐럴이 사라진 원인은 저작권 문제보다 소음 및 에너지 규제가 더 큰 비중을 차지한다.

🎤 거리 캐럴의 부활을 위한 과제

길거리 캐럴이 사라진 배경에는 소음 규제와 에너지 효율 문제가 크다. 연말 분위기를 되살리기 위해서는 시민과 상인 간의 합의, 규제 완화 방안, 에너지 효율적인 방법 등이 논의되어야 할 것이다.