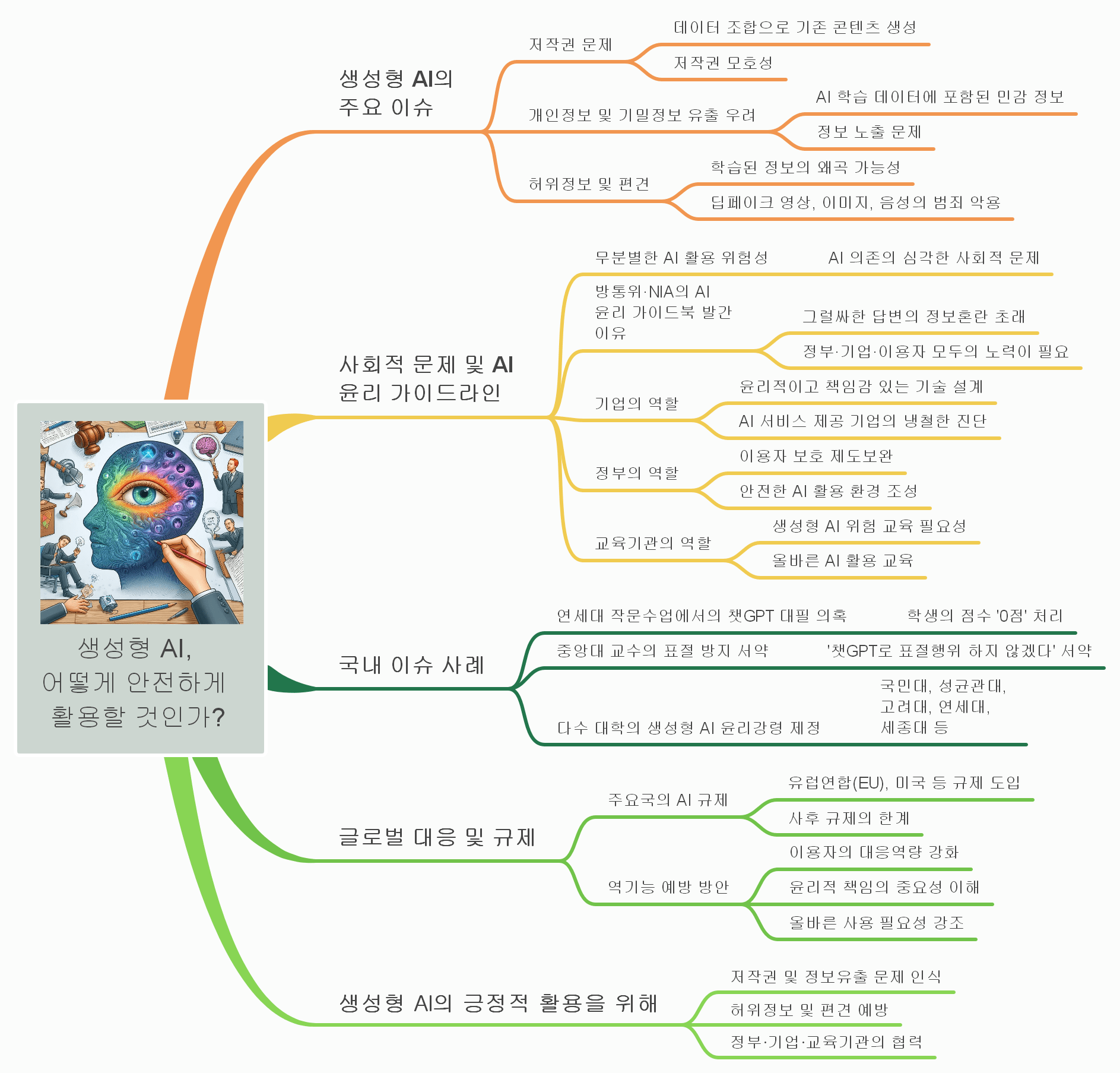

생성형 AI의 주요 이슈

생성형 AI는 다양한 분야에서 유용하게 활용될 수 있는 기술이지만, 그 과정에서 여러 가지 문제가 발생할 수 있다. 특히, 저작권 문제, 개인정보 및 기밀정보 유출 우려, 허위정보 및 편견 등이 주요 이슈로 대두되고 있다.

저작권 문제

생성형 AI는 대량의 데이터를 바탕으로 콘텐츠를 생성하는데, 이 과정에서 기존 콘텐츠를 결합하거나 변형하여 새로운 결과물을 만들어낸다. 하지만 이처럼 데이터가 조합된 결과물이 기존의 저작권을 침해할 가능성이 있으며, 저작권 보호와 AI 생성물의 저작권 사이에 모호함이 존재하게 된다.

개인정보 및 기밀정보 유출 우려

생성형 AI가 학습하는 데이터에는 민감한 정보도 포함될 수 있어 개인정보가 유출될 가능성이 있다. 이로 인해 AI가 생성한 결과물이 개인정보를 노출하거나 기밀 정보를 유출할 수 있는 위험성이 제기되고 있다.

허위정보 및 편견

AI는 학습된 데이터를 바탕으로 결과를 도출하는데, 이 과정에서 왜곡된 정보나 편향된 시각이 그대로 반영될 수 있다. 또한, 딥페이크 기술을 이용해 가짜 영상, 이미지, 음성을 생성하는 경우, 이를 범죄에 악용할 수 있다는 문제점도 존재한다.

사회적 문제와 AI 윤리 가이드라인

AI의 발전은 많은 편의를 제공하지만, 무분별한 AI 활용은 사회적으로 심각한 문제를 초래할 수 있다. 이를 방지하기 위해 방통위와 한국정보화진흥원(NIA)은 AI 윤리 가이드북을 발간하여 정부, 기업, 이용자 모두의 협력이 필요하다는 점을 강조하고 있다.

기업의 역할

생성형 AI를 제공하는 기업은 윤리적이고 책임감 있는 기술을 설계하고 제공해야 한다. 기술의 위험성을 냉철하게 진단하여 문제가 발생하지 않도록 관리할 필요가 있다.

정부의 역할

정부는 AI 이용자를 보호하기 위해 제도를 보완하고, 안전한 AI 활용 환경을 조성해야 한다. 특히, 허위정보나 개인정보 유출을 방지하기 위한 정책 마련이 필수적이다.

교육기관의 역할

교육기관에서는 생성형 AI의 위험성과 올바른 활용 방법을 교육할 필요가 있다. 학생들이 AI를 도구로서 적절히 사용할 수 있도록 윤리적 교육과정을 마련해야 한다.

국내 이슈 사례

생성형 AI의 부정적 사용을 방지하기 위해, 국내 대학들에서도 다양한 윤리적 조치가 시행되고 있다. 예를 들어, 연세대에서는 작문수업에서 챗GPT를 이용한 대필이 의심되어 해당 학생의 점수를 ‘0점’으로 처리했다. 중앙대의 경우, 교수들이 ‘챗GPT로 표절하지 않겠다’는 서약을 요구하기도 한다. 또한 국민대, 성균관대, 고려대, 연세대, 세종대 등 여러 대학에서 생성형 AI 윤리강령을 제정하여 학생들에게 올바른 AI 활용 방법을 강조하고 있다.

글로벌 대응 및 규제

주요국에서도 생성형 AI의 역기능을 방지하기 위한 규제를 도입하고 있다. 유럽연합(EU)과 미국 등은 사후 규제와 더불어 이용자의 대응역량을 강화하는 방식으로 AI 규제에 나서고 있다. 하지만 이러한 규제에는 한계가 있으며, 무엇보다도 윤리적 책임과 올바른 사용이 중요하다는 인식이 필요하다.

생성형 AI의 긍정적 활용을 위해

생성형 AI를 긍정적으로 활용하려면, 저작권 및 정보유출 문제를 인식하고 허위정보 및 편견을 예방하는 것이 중요하다. 이를 위해 정부, 기업, 교육기관이 협력하여 안전하고 책임감 있는 AI 환경을 조성하는 것이 필요하다.